Multipathing für Speicher

Wichtig:

Citrix Hypervisor 8.2 Kumulatives Update 1 wird am 25. Juni 2025 End of Life. Planen Sie jetzt Ihr Upgrade auf XenServer 8.4, um einen reibungslosen Übergang und kontinuierlichen Support sicherzustellen. Weitere Informationen finden Sie unter Upgrade.

Wenn Sie Ihre Citrix Virtual Apps and Desktops-Lizenzdateien zum Lizenzieren Ihrer Citrix Hypervisor 8.2 Cumulative Update 1-Hosts verwenden, sind diese Lizenzdateien nicht mit XenServer 8.4 kompatibel. Vor dem Upgrade müssen Sie Socket-Lizenzdateien für XenServer Premium Edition erwerben, um sie mit XenServer 8.4 verwenden zu können. Diese Socket-Lizenzdateien sind als Berechtigung für die Abonnements Citrix für Private Cloud, Citrix Universal Hybrid Multi-Cloud, Citrix Universal MSP und Citrix Platform License für die Ausführung Ihrer Citrix-Workloads verfügbar. Citrix-Kunden, die noch nicht auf diese neuen Abonnements umgestiegen sind, können die Teilnahme an einer kostenlosen Aktion für 10.000 XenServer Premium Edition-Socket-Lizenzen anfordern. Weitere Informationen finden Sie unter XenServer (Englisch).

Wenn Sie vor dem Upgrade keine kompatible Lizenz für XenServer 8.4 erwerben, werden Ihre Hosts beim Upgrade auf die 90-Tage-Testversion zurückgesetzt. Die Testversion bietet die gleichen Funktionen wie die Premium Edition, jedoch mit einigen Einschränkungen. Weitere Informationen finden Sie unter XenServer 8.4-Lizenzübersicht.

Für Fibre Channel- und iSCSI-Speicher-Backends ist dynamische Multipathing-Unterstützung verfügbar.

Citrix Hypervisor verwendet Linux Native Multipathing (DM-MP), die generische Linux-Multipathing-Lösung, als Multipath-Handler. Citrix Hypervisor ergänzt diesen Handler jedoch um zusätzliche Funktionen, sodass Citrix Hypervisor herstellerspezifische Funktionen von Speichergeräten erkennen kann.

Die Konfiguration von Multipathing bietet Redundanz für den Remote-Speicherdatenverkehr, wenn die Konnektivität teilweise verloren geht. Multipathing leitet den Speicherdatenverkehr über mehrere Pfade an ein Speichergerät weiter, um Redundanz zu gewährleisten und den Durchsatz zu erhöhen. Sie können bis zu 16 Pfade zu einer einzelnen LUN verwenden. Multipathing ist eine Aktiv-Aktiv-Konfiguration. Standardmäßig wird beim Multipathing je nach Speicherarraytyp entweder ein Roundrobin- oder ein Multibus-Lastenausgleich verwendet. Alle Routen sind während des normalen Betriebs mit aktivem Verkehr befahren, was zu einem erhöhten Durchsatz führt.

Wichtig:

Es wird empfohlen, Multipathing für alle Server in Ihrem Pool zu aktivieren vor Erstellen der SR. Wenn Sie die SR erstellen, bevor Sie Multipathing aktivieren, müssen Sie Ihre Server in den Wartungsmodus versetzen, um Multipathing zu aktivieren.

NIC-Bonding kann auch Redundanz für den Speicherdatenverkehr bieten. Für iSCSI-Speicher wird empfohlen, nach Möglichkeit Multipathing anstelle von NIC-Bonding zu konfigurieren.

Multipathing ist in den folgenden Szenarien nicht effektiv:

- NFS-Speichergeräte

- Sie verfügen über eine begrenzte Anzahl von Netzwerkkarten und müssen iSCSI-Datenverkehr und Dateidatenverkehr (NFS oder SMB) über dieselbe Netzwerkkarte weiterleiten

In diesen Fällen sollten Sie stattdessen die Verwendung von NIC-Bonding in Betracht ziehen. Weitere Informationen zum NIC-Bonding finden Sie unter Vernetzung.

Voraussetzungen

Bevor Sie Multipathing aktivieren, stellen Sie sicher, dass die folgenden Aussagen wahr sind:

-

Auf Ihrem Speicherserver sind mehrere Ziele verfügbar.

Ein iSCSI-Speicher-Back-End, das z. B. nach

Ziele sendenfür ein bestimmtes Portal gibt mehrere Ziele zurück, wie im folgenden Beispiel gezeigt:iscsiadm -m discovery --type sendtargets --portal 192.168.0.161 192.168.0.161:3260,1 iqn.strawberry:litchie 192.168.0.204:3260,2 iqn.strawberry:litchieSie können jedoch eine zusätzliche Konfiguration vornehmen, um iSCSI-Multipath für Arrays zu aktivieren, die nur ein einzelnes Ziel verfügbar machen. Weitere Informationen finden Sie unter iSCSI-Multipath für Arrays, die nur ein einzelnes Ziel verfügbar machen.

-

Nur für iSCSI verfügt die Steuerdomäne (dom0) über eine IP-Adresse in jedem Subnetz, das vom Multipath-Speicher verwendet wird.

Stellen Sie sicher, dass Sie für jeden Pfad, den Sie zum Speicher haben möchten, über eine Netzwerkkarte verfügen und dass auf jeder Netzwerkkarte eine IP-Adresse konfiguriert ist. Wenn Sie z. B. vier Pfade zu Ihrem Speicher benötigen, müssen Sie über vier Netzwerkkarten verfügen, für die jeweils eine IP-Adresse konfiguriert ist.

-

Nur für iSCSI verfügt jedes iSCSI-Ziel und jeder iSCSI-Initiator über einen eindeutigen IQN.

-

Nur für iSCSI werden die iSCSI-Zielports im Portalmodus betrieben.

-

Nur für HBAs sind mehrere HBAs mit der Switch-Fabric verbunden.

-

Wenn Sie sekundäre Schnittstellen konfigurieren, muss sich jede sekundäre Schnittstelle in einem separaten Subnetz befinden. Wenn Sie z. B. zwei weitere sekundäre Schnittstellen für den Speicher konfigurieren möchten, benötigen Sie IP-Adressen in drei verschiedenen Subnetzen – einem Subnetz für die Verwaltungsschnittstelle, einem Subnetz für die sekundäre Schnittstelle 1 und einem Subnetz für die sekundäre Schnittstelle 2.

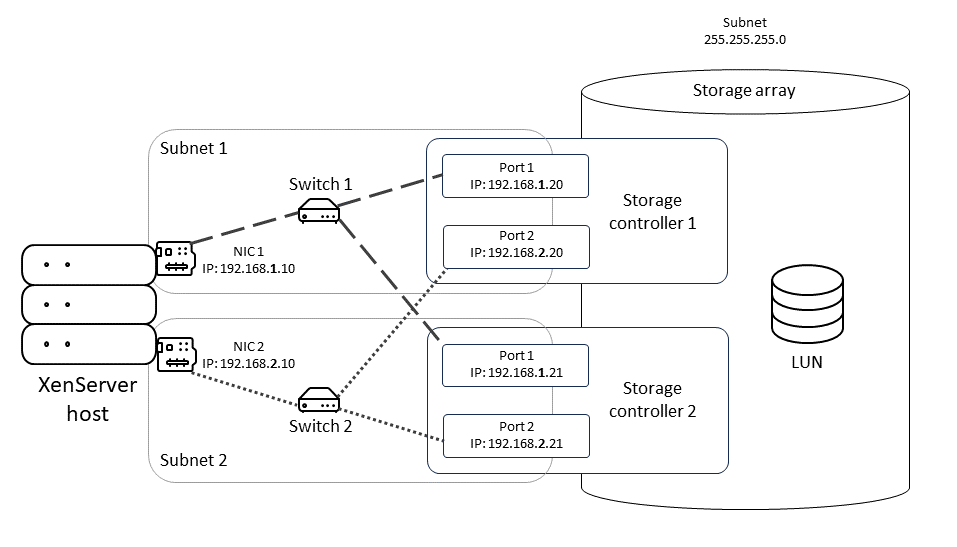

Dieses Diagramm zeigt, wie sich beide Netzwerkkarten auf dem Host in einer iSCSI-Konfiguration mit mehreren Pfaden in unterschiedlichen Subnetzen befinden müssen. In diesem Diagramm befinden sich NIC 1 auf dem Host zusammen mit Switch 1 und NIC 1 auf beiden Speichercontrollern in einem anderen Subnetz als NIC2, Switch 2 und NIC 2 auf den Speichercontrollern.

Multipathing aktivieren

Sie können Multipathing in XenCenter oder in der xe CLI aktivieren.

So aktivieren Sie Multipathing mithilfe von XenCenter

-

Im XenCenter Betriebsmittel , klicken Sie mit der rechten Maustaste auf den Server, und wählen Sie Wechseln Sie in den Wartungsmodus.

-

Warten Sie, bis der Server wieder in der Betriebsmittel mit dem Symbol für den Wartungsmodus (ein blaues Quadrat), bevor Sie fortfahren.

-

Am Allgemein für den Server, klicken Sie auf Eigenschaften und gehen Sie dann zum Multipathing Registerkarte.

-

Um Multipathing zu aktivieren, wählen Sie die Schaltfläche Aktivieren von Multipathing auf diesem Server Kontrollkästchen.

-

Klicken OKAY , um die neue Einstellung zu übernehmen. Es gibt eine kurze Verzögerung, während XenCenter die neue Speicherkonfiguration speichert.

-

Im Betriebsmittel , klicken Sie mit der rechten Maustaste auf den Server, und wählen Sie Wartungsmodus beenden.

-

Wiederholen Sie diese Schritte, um Multipathing auf allen Servern im Pool zu aktivieren.

Stellen Sie sicher, dass Sie Multipathing auf allen Servern im Pool aktivieren. Die gesamte Verkabelung und, im Falle von iSCSI, die Subnetzkonfigurationen müssen mit den entsprechenden Netzwerkkarten auf jedem Server übereinstimmen.

So aktivieren Sie Multipathing mithilfe der xe CLI

-

Öffnen Sie eine Konsole auf dem Citrix Hypervisor-Server.

-

Trennen Sie alle PBDs auf dem Server mit dem folgenden Befehl:

xe pbd-unplug uuid=<pbd_uuid> <!--NeedCopy-->Sie können den Befehl

XE PBD-Liste, um die UUID der PBDs zu finden. -

Legen Sie den Wert der

MultipathingParameter aufSTIMMTmit dem folgenden Befehl:xe host-param-set uuid=<host uuid> multipathing=true <!--NeedCopy--> -

Wenn auf dem Server SRs vorhanden sind, die im Einzelpfadmodus ausgeführt werden, aber über mehrere Pfade verfügen:

-

Migrieren oder Anhalten aller ausgeführten Gäste mit virtuellen Festplatten in den betroffenen SRs

-

Schließen Sie die PBD aller betroffenen SRs wieder an, um sie mithilfe von Multipathing wieder zu verbinden:

xe pbd-plug uuid=<pbd_uuid> <!--NeedCopy-->

-

-

Wiederholen Sie diese Schritte, um Multipathing auf allen Servern im Pool zu aktivieren.

Stellen Sie sicher, dass Sie Multipathing auf allen Servern im Pool aktivieren. Die gesamte Verkabelung und, im Falle von iSCSI, die Subnetzkonfigurationen müssen mit den entsprechenden Netzwerkkarten auf jedem Server übereinstimmen.

Multipathing deaktivieren

Sie können Multipathing in XenCenter oder in der xe CLI deaktivieren.

So deaktivieren Sie Multipathing mithilfe von XenCenter

-

Im XenCenter Betriebsmittel , klicken Sie mit der rechten Maustaste auf den Server, und wählen Sie Wechseln Sie in den Wartungsmodus.

-

Warten Sie, bis der Server wieder in der Betriebsmittel mit dem Symbol für den Wartungsmodus (ein blaues Quadrat), bevor Sie fortfahren.

-

Am Allgemein für den Server, klicken Sie auf Eigenschaften und gehen Sie dann zum Multipathing Registerkarte.

-

Um Multipathing zu deaktivieren, deaktivieren Sie das Symbol Aktivieren von Multipathing auf diesem Server Kontrollkästchen.

-

Klicken OKAY , um die neue Einstellung zu übernehmen. Es gibt eine kurze Verzögerung, während XenCenter die neue Speicherkonfiguration speichert.

-

Im Betriebsmittel , klicken Sie mit der rechten Maustaste auf den Server, und wählen Sie Wartungsmodus beenden.

-

Wiederholen Sie diese Schritte, um Multipathing auf allen Servern im Pool zu konfigurieren.

So deaktivieren Sie Multipathing mithilfe der xe CLI

-

Öffnen Sie eine Konsole auf dem Citrix Hypervisor-Server.

-

Trennen Sie alle PBDs auf dem Server mit dem folgenden Befehl:

xe pbd-unplug uuid=<pbd_uuid> <!--NeedCopy-->Sie können den Befehl

XE PBD-Liste, um die UUID der PBDs zu finden. -

Legen Sie den Wert der

MultipathingParameter aufFALSCHmit dem folgenden Befehl:xe host-param-set uuid=<host uuid> multipathing=false <!--NeedCopy--> -

Wenn auf dem Server SRs vorhanden sind, die im Einzelpfadmodus ausgeführt werden, aber über mehrere Pfade verfügen:

-

Migrieren oder Anhalten aller ausgeführten Gäste mit virtuellen Festplatten in den betroffenen SRs

-

Trennen Sie die PBD aller betroffenen SRs und stecken Sie sie wieder ein, um sie mithilfe von Multipathing wieder zu verbinden:

xe pbd-plug uuid=<pbd_uuid> <!--NeedCopy-->

-

-

Wiederholen Sie diese Schritte, um Multipathing auf allen Servern im Pool zu deaktivieren.

Konfigurieren von Multipathing

Um zusätzliche temporäre Änderungen an der Multipath-Konfiguration vorzunehmen, erstellen Sie Dateien mit dem Suffix .Conf im Verzeichnis /etc/multipath/conf.d. Fügen Sie die zusätzliche Konfiguration in diesen Dateien hinzu. Multipath durchsucht das Verzeichnis alphabetisch nach Dateien, die auf .Conf und liest Konfigurationsinformationen aus ihnen.

Bearbeiten Sie die Datei nicht /etc/multipath.conf. Diese Datei wird durch Updates für Citrix Hypervisor überschrieben. Wenn Sie dauerhafte Änderungen an Ihrer Multipathing-Konfiguration vornehmen möchten, wenden Sie sich an Ihren Speicheranbieter, der unser Partner-Engineering-Team auffordern kann, die Änderungen dauerhaft hinzuzufügen.

iSCSI-Multipathing in einem einzelnen Subnetz

Sie können Citrix Hypervisor so konfigurieren, dass iSCSI Multipath mit Speicherarrays verwendet wird, die ihre Ziele und IQN(s) in einem einzelnen Subnetz verfügbar machen. Sie können beispielsweise die folgenden Schritte ausführen, um Dell EqualLogic PS- und FS-Unified-Series-Speicher-Arrays einzurichten.

Standardmäßig stellt Citrix Hypervisor nur eine Verbindung pro iSCSI-Ziel her. Daher wird empfohlen, bei der Standardkonfiguration NIC-Bonding zu verwenden, um Failover und Lastausgleich zu erreichen. Das in diesem Abschnitt beschriebene Konfigurationsverfahren beschreibt eine alternative Konfiguration, bei der mehrere iSCSI-Verbindungen für ein einzelnes Subnetz oder Ziel hergestellt werden. Eine NIC-Verklebung ist nicht erforderlich.

Hinweis:

Die folgende Konfiguration wird nur für Server unterstützt, die ausschließlich an Speicher-Arrays angeschlossen sind, die ihre Ziele und IQNs über ein einzelnes Subnetz verfügbar machen. Diese Speicherarrays müssen für dieses Verfahren mit Citrix Hypervisor qualifiziert werden.

So konfigurieren Sie Multipath:

-

Sichern Sie alle Daten, die Sie schützen möchten.

-

Im XenCenter Betriebsmittel , klicken Sie mit der rechten Maustaste auf den Server, und wählen Sie Wechseln Sie in den Wartungsmodus.

-

Warten Sie, bis der Server wieder in der Betriebsmittel mit dem Symbol für den Wartungsmodus (ein blaues Quadrat), bevor Sie fortfahren.

-

Am Allgemein für den Server, klicken Sie auf Eigenschaften und gehen Sie dann zum Multipathing Registerkarte.

-

Um Multipathing zu aktivieren, wählen Sie die Schaltfläche Aktivieren von Multipathing auf diesem Server Kontrollkästchen.

-

Klicken OKAY , um die neue Einstellung zu übernehmen. Es gibt eine kurze Verzögerung, während XenCenter die neue Speicherkonfiguration speichert.

-

Konfigurieren Sie in der Serverkonsole zwei bis vier Open-iSCSI-Schnittstellen. Jede iSCSI-Schnittstelle wird verwendet, um einen separaten Pfad einzurichten. Die folgenden Schritte zeigen den Prozess für zwei Schnittstellen:

-

Konfigurieren Sie zwei iSCSI-Schnittstellen, und führen Sie die folgenden Befehle aus:

iscsiadm -m iface --op new -I c_iface1 iscsiadm -m iface --op new -I c_iface2Stellen Sie sicher, dass die Schnittstellennamen das Präfix

c_. Wenn die Schnittstellen diesen Benennungsstandard nicht verwenden, werden sie ignoriert und stattdessen die Standardschnittstelle verwendet.Hinweis:

Diese Konfiguration führt dazu, dass für alle Verbindungen die Standardschnittstelle verwendet wird. Dies bedeutet, dass alle Verbindungen über eine einzige Schnittstelle hergestellt werden.

-

Binden Sie die iSCSI-Schnittstellen mit den folgenden Befehlen an xenbr1 und xenbr2:

iscsiadm -m iface --op update -I c_iface1 -n iface.net_ifacename -v xenbr1 iscsiadm -m iface --op update -I c_iface2 -n iface.net_ifacename -v xenbr2Hinweis:

Bei dieser Konfiguration wird davon ausgegangen, dass die für die Steuerdomäne konfigurierten Netzwerkschnittstellen (einschließlich xenbr1 und xenbr2) und xenbr0 für die Verwaltung verwendet werden. Außerdem wird davon ausgegangen, dass es sich bei den für das Speichernetzwerk verwendeten NIC-Karten um NIC1 und NIC2 handelt. Wenn dies nicht der Fall ist, suchen Sie in Ihrer Netzwerktopologie nach den Netzwerkschnittstellen und Netzwerkkarten, die in diesen Befehlen verwendet werden sollen.

-

-

Im XenCenter Betriebsmittel , klicken Sie mit der rechten Maustaste auf den Server, und wählen Sie Wartungsmodus beenden. Setzen Sie Ihre VMs noch nicht fort.

-

Führen Sie in der Serverkonsole die folgenden Befehle aus, um die Sitzungen zu ermitteln und sich bei ihnen anzumelden:

iscsiadm -m discovery -t st -p <IP of SAN> iscsiadm -m node -L all -

Löschen Sie die veralteten Einträge mit alten Sitzungsinformationen mit den folgenden Befehlen:

cd /var/lib/iscsi/send_targets/<IP of SAN and port, use ls command to check that> rm -rf <iqn of SAN target for that particular LUN> cd /var/lib/iscsi/nodes/ rm -rf <entries for that particular SAN> -

Nehmen Sie die LUN ab und schließen Sie sie wieder an. Sie können dies auf eine der folgenden Arten tun:

- Nachdem Sie die vorherigen Schritte auf allen Servern in einem Pool ausgeführt haben, können Sie XenCenter verwenden, um die LUN für den gesamten Pool zu trennen und wieder anzuhängen.

-

Alternativ können Sie die PBD für jeden Server vom Stromnetz trennen und zerstören und dann die SR reparieren.

-

Führen Sie die folgenden Befehle aus, um die PBD vom Stromnetz zu trennen und zu zerstören:

-

Suchen Sie die UUID des SR:

xe sr-list -

Rufen Sie die Liste der PBDs ab, die der SR zugeordnet sind:

xe pbd-list sr-uuid=<sr_uuid> -

Suchen Sie in der Ausgabe des vorherigen Befehls nach der UUID der PBD des iSCSI-Speicherrepositorys mit einer nicht übereinstimmenden SCSI-ID.

-

Ziehen Sie den Netzstecker und vernichten Sie die PBD, die Sie identifiziert haben.

xe pbd-unplug uuid=<pbd_uuid> xe pbd-destroy uuid=<pbd_uuid>

-

-

Reparieren Sie den Speicher in XenCenter.

-

-

Sie können Ihre VMs jetzt fortsetzen.